Soeben ist mein neuer Roman erschienen – nein, Korrektur: unser neuer Roman. Denn “Zeitschaden” ist eine echte Koproduktion: Mit meinem guten Freund und geschätzten Autorenkollegen Uwe Hermann. Lange haben wir ein Geheimnis draus gemacht, aber auf dem ElsterCon Mitte September in Leipzig haben wir es dann gelüftet. Inzwischen ist der Roman erschienen und für nur 10 Euro (Paperback) erhältlich! E-Book folgt in Kürze.

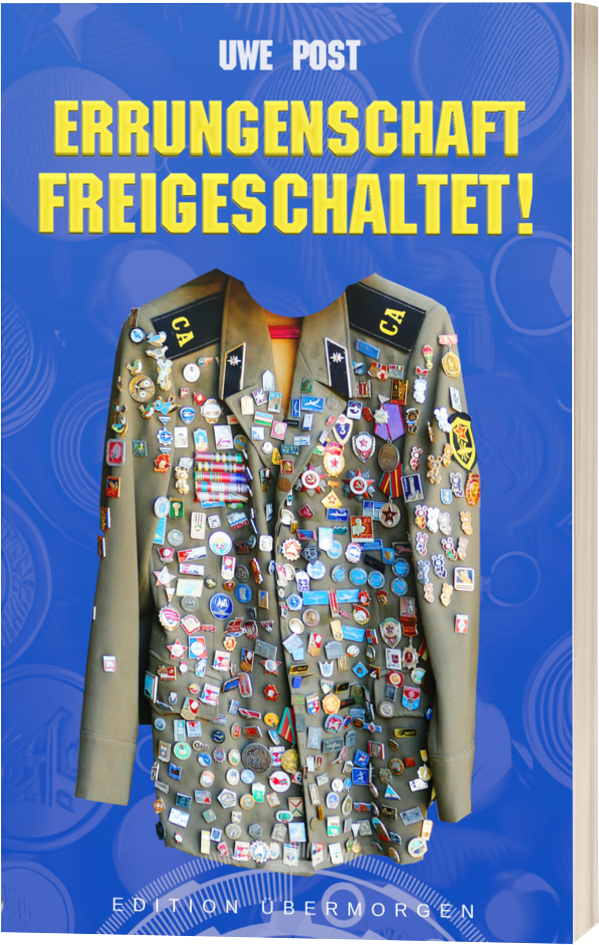

Lustigerweise geht das Projekt auf meinen Aprilscherz dieses Jahr zurück. Dort zeigte ich nebenstehendes Cover (allerdings mit nur meinem Namen drauf) und behauptete, das sei mein nächster Roman. Da ich aber bekanntlich Zeitreise-Geschichten total blöd finde, war es ein offensichtlicher Scherz. Nun ist aus dem Scherz witziger Ernst geworden! Denn dieser Roman der beiden wohl lustigsten Uwes der deutschen SF ist ziemlich komisch geworden.

Worum geht’s? Hier kommt der Klappentext:

Die Zeit hat einen Schaden, und zwar in Schränken.London 1870, Berlin 1920, Duisburg 1985: Aus Kleiderschränken purzeln Menschen, die aus der jeweiligen Zukunft stammen. Der 28-Jährigen Hamburgerin Lucia fällt im Winter 2023 auf diese Weise ein Saugbot mit Psychiater-Plugin vor die Füße. Die Zeit hat ganz offensichtlich einen Schaden in diesem Schrank! Aber was hat der 55-jährige Computernerd damit zu tun, der im Jahr 1985 in Duisburg aufgetaucht ist und sich dort anscheinend pudelwohl fühlt?

Eine Achterbahnfahrt durch die Zeit sowie durch Zeitreise-Kakao von und mit den beiden wohl lustigsten Uwes der deutschen SF.

Nachdem wir das Exposé entwickelt hatten, haben wir die Handlungsebenen untereinander aufgeteilt, unabhängig voneinander geschrieben, zwischendurch gegenseitig gelesen und am Schluss zusammengefügt wie ein Puzzle. Dann haben wir das Finale gemeinsam verfasst – mit Cocktails am Pool. Herausgekommen ist ein großer Spaß mit bösen Aliens, schrägen Gestalten und Jules Verne. Ein beliebter Quiz für Leser ist es übrigens, zu raten, wer welche Kapitel geschrieben hat … die Anfangsbuchstaben ergeben aber kein Lösungswort!

Der Roman erscheint im Selbstverlag (aber natürlich mit ordentlichem Layout und Korrektorat) bei BoD in unserer neu gegründeten “Edition Übermorgen”, wo all jene unserer Geschichten erscheinen werden, die üblichen Verlagen zu riskant sind.

Paperback nur €10 · kaufen bei BoD · Amazon